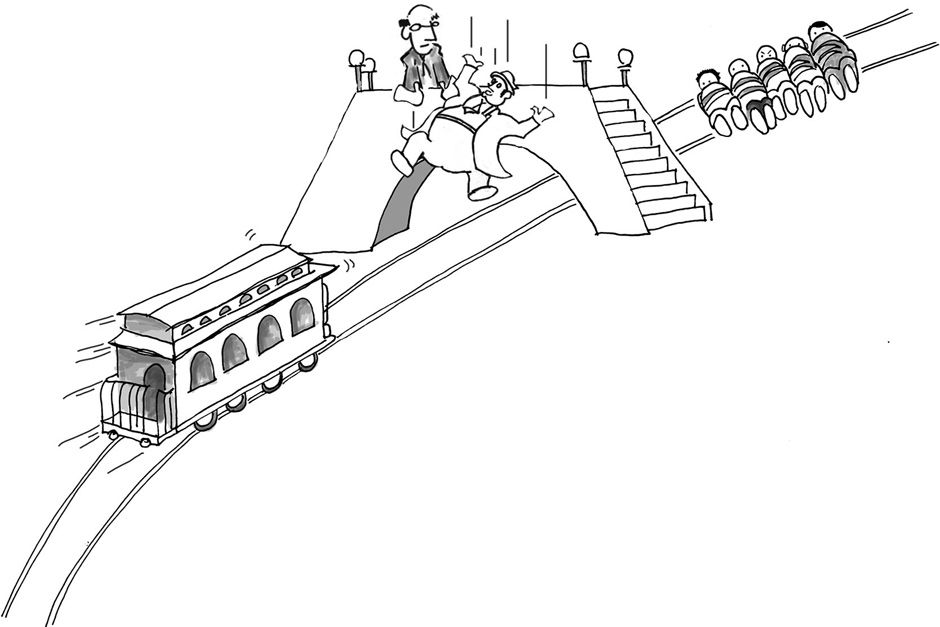

Un tram sta viaggiando a tutta velocità e lungo il suo tragitto ci sono cinque persone che, inevitabilmente, verrebbero travolte dal mezzo e perderebbero la vita. Il veicolo, vista la forte velocità, non riuscirebbe a fermarsi in tempo.

Tu sei sopra un ponte che stai vedendo tutto ciò e assieme a te c’è un uomo, dalla massa così elevata, che se gettato giù riuscirebbe a fermare il tram in corsa (non fatevi troppe domande è un dilemma morale non di fisica).

Uccideresti quell’uomo, salvando la vita alle cinque persone legate ai binari? Lo getteresti giù sacrificando una vita per non perderne cinque? Sai che non puoi sacrificarti buttandoti, in quanto non hai la massa sufficiente per fermare il tram, che fai?

David Edmonds in un suo libro (da cui abbiamo rubato il titolo per questo articolo) indaga sulla carrellologia, branca della filosofia morale che studia situazioni simili all’immagine descritta. Nelle moderne rappresentazioni si è sostituito l’uomo grasso con l’uomo pesante o l’uomo con lo zaino, noi siamo rimasti fedeli alla trattazione originale.

La domanda appare molto teorica ma è un quesito che regola molti aspetti decisionali della politica.

Immaginate di poter salvare un paziente con una massiccia dose di un farmaco, oppure di poterne salvare cinque che necessitano di un quinto ciascuno di questo farmaco, cosa fareste?

Probabilmente il principio utilitaristico vi spingerà a salvarne il numero maggiore, creando la situazione definita dagli anglosassoni come “il dilemma del diavolo” in cui qualsiasi decisione presa porta conseguenze negative.

I filosofi si perdono in mille altre sfumature su casi di tram ipotetici lanciati a tutta velocità, ma non essendo del mestiere lasciamo quelle trattazioni a chi di dovere e preferiamo concentrarci su una questione più attuale che mai: le auto a guida autonoma.

In quest’altra immagine, più elaborata, si vede un’auto con all’interno quattro persone. Come il tram, anche questo veicolo non riuscirebbe a frenare in tempo per evitare i pedoni sulle strisce. Le alternative sono quelle raffigurate di seguito, da una parte l’auto si schianta su un ostacolo causando la morte dei passeggeri, dall’altra investe i passanti.

È un dilemma che rapidamente la nostra mente risolve se siamo alla guida, non per forza ci sarà la stessa risposta per tutti. I dilemmi potrebbero continuare con mille sfaccettature e la risposta potrebbe cambiare da situazione a situazione.

L’esempio dell’immagine successiva mostra dei passanti che stanno attraversando la strada.

Nessuno è in auto, essendo a guida autonoma. Fatalità vuole che in quel momento stiano attraversano la strada alcuni pedoni.

La vettura ha una velocità troppo elevata per fermarsi, può decidere però di cambiare corsia per investire i passanti che sono ormai alla fine delle strisce.

Questi ultimi sono persone facoltose, che sono passate però con il rosso, le altre, che sono invece passate con il verde, sono senzatetto, senza una lira.

Quale decisione sarebbe giusta da prendere?

A seconda dei valori che abbiamo e dell’educazione che ci è stata data, ognuno risponderà a modo proprio, dando una propria soluzione.

Ovviamente sono ipotesi ai limiti della concretezza, l’auto potrebbe andare contro il marciapiede non facendo perdere la vita a nessuno. Tuttavia questi dubbi filosofici hanno dei limiti molto sottili.

Non esiste una risposta assoluta sulla decisione corretta da prendere. Alcuni ricercatori del MIT di Boston hanno pubblicato sul sito moralmachine.net questi quesiti sotto forma di quiz mostrando la variabilità delle risposte delle varie persone (le immagini sono tratte da quel sito).

Si è notato come la società, il paese, l’età in cui si vive condizionino il modo di rispondere. Stati come il Giappone ripongono molto più valore agli anziani piuttosto che l’Occidente ad esempio e sono più propensi a salvare le loro vite, visto l’esperienza che possono diffondere nella società.

Tornado alle auto, come dovrebbe essere tarato un algoritmo per la guida autonoma?

Dovrebbe puntare a difendere ad ogni costo il conducente, anche mettendo a repentaglio più vite umane?

Oppure dovrebbe considerare il principio utilitaristico e quindi salvare il maggior numero possibile di vite, nell’ipotesi in cui non vi siano soluzioni alternative?

In quel caso, se vi sono diversi passanti e un solo conducente potrebbe optare per far finire fuori strada il veicolo, compromettendo la vita della persona. Ma chi comprerebbe un’auto sapendo che è programmata per buttarsi fuori strada inseguendo il principio di più vite salvate meglio è, a discapito di colui che ha speso soldi per acquistare il veicolo?

Gli algoritmi assieme all’intelligenza artificiale e le informazioni dei database saranno il futuro.

Sono esseri umani che progettano la tecnologia e creare una struttura in grado di prendere decisioni per conto nostro implica, oltre che notevoli responsabilità, anche una formulazione adeguata.

Per le decisioni morali, non c’è un’assoluta verità, perché tornando alla prima immagine, la deontologia affermerebbe che non bisognerebbe prendere l’iniziativa per sacrificare un uomo che sta bene perché questo viola la sua libertà, anche se questo può salvare più vite, chi siamo noi per togliere una vita?

Se quell’uomo è però un assassino la nostra idea sull’agire può cambiare, in base al nostro livello di morale.

Etica e tecnologia devono collaborare assieme. Chissà se una macchina potrà mai prendere decisioni nella stessa maniera di noi umani.

Vi è la sensazione che lo sapremo a breve.